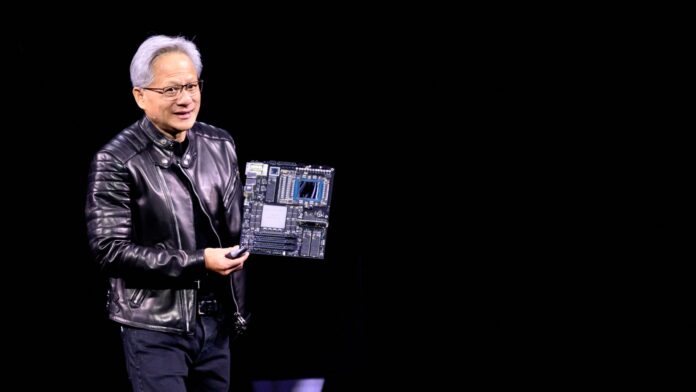

O CEO da NVIDIA, Jensen Huang, apresenta novos produtos enquanto entrega o discurso na conferência da GTC AI em San Jose, Califórnia, em 18 de março de 2025.

Josh Edelson | AFP | Getty Images

No final de Nvidia A palestra de duas horas do CEO Jensen Huang na terça-feira, sua mensagem foi clara: obtenha os chips mais rápidos que a empresa faz.

Falando na conferência GTC da NVIDIA, Huang disse que as perguntas que os clientes têm sobre o custo e o retorno do investimento que os processadores gráficos da empresa, ou GPUs, desaparecerão com chips mais rápidos que podem ser cortados digitalmente e servir para servir inteligência artificial a milhões de pessoas no mesmo tempo.

“Nos próximos 10 anos, porque pudemos ver melhorando o desempenho tão dramaticamente, a velocidade é o melhor sistema de redução de custos”, disse Huang em uma reunião com jornalistas logo após sua palestra no GTC.

A empresa dedicou 10 minutos durante o discurso de Huang para explicar a economia de chips mais rápidos para provedores de nuvem, completos com Huang fazendo matemática envelope em voz alta no custo por toque de cada chip, uma medida de quanto custa para criar uma unidade de saída de IA.

Huang disse aos repórteres que ele apresentou as contas, porque é isso que está na mente das empresas de nuvem de hiperescala e IA.

O Blackwell Ultra Systems da empresa, lançado este ano, poderia fornecer aos data centers 50 vezes mais receita do que seus sistemas de tremonha, porque é muito mais rápido em servir a IA a vários usuários, diz a Nvidia.

Os investidores se preocupam se os quatro principais provedores de nuvem – MicrosoftAssim, GoogleAssim, Amazon e Oráculo – poderia desacelerar seu ritmo tórrido de despesas de capital centrado nas cartas de fichas de IA. A Nvidia não revela preços para seus chips de IA, mas os analistas dizem que Blackwell pode custar US $ 40.000 por GPU.

Os quatro maiores fornecedores de nuvem já compraram 3,6 milhões de GPUs Blackwell, sob a nova convenção da Nvidia, que conta cada Blackwell como 2 GPUs. Isso é de 1,3 milhão de GPUs Hopper, disse a Nvidia de Blackwell, na Nvidia.

A empresa decidiu anunciar seu roteiro para o Rubin Next de 2027 e o Feynman AI Chips, de 2028, disse Huang, porque os clientes da nuvem já estão planejando data centers caros e querem conhecer os golpes amplos dos planos da Nvidia.

“Sabemos agora, enquanto falamos, em alguns anos, várias centenas de dólares em infraestrutura de IA” serão construídos, disse Huang. “Você aprovou o orçamento. Você aprovou o poder. Você conseguiu a terra”.

Huang descartou a noção de que chips personalizados dos provedores de nuvem poderiam desafiar as GPUs da NVIDIA, argumentando que eles não são flexíveis o suficiente para os algoritmos de IA em movimento rápido. Ele também expressou dúvidas de que muitos dos chips de IA personalizados recentemente anunciados, conhecidos na indústria como ASICs, chegariam ao mercado.

“Muitos ASICs são cancelados”, disse Huang. “O ASIC ainda precisa ser melhor que o melhor.”

Huang disse que o seu foco é garantir que esses grandes projetos usem os melhores e mais recentes sistemas NVIDIA.

“Então a pergunta é: o que você quer por vários US $ 100 bilhões?” Huang disse.

ASSISTIR: Entrevista completa da CNBC com o CEO da NVIDIA Jensen Huang